España busca adaptar su normativa a la era de la inteligencia artificial

La evolución de las tecnologías de creación de imágenes y el creciente protagonismo de la inteligencia artificial (IA) en los últimos años han desencadenado un amplio espectro de oportunidades en la gran mayoría de sectores. Sin embargo, este avance vertiginoso también ha suscitado retos y dilemas, especialmente debido a la falta de una regulación adecuada […]

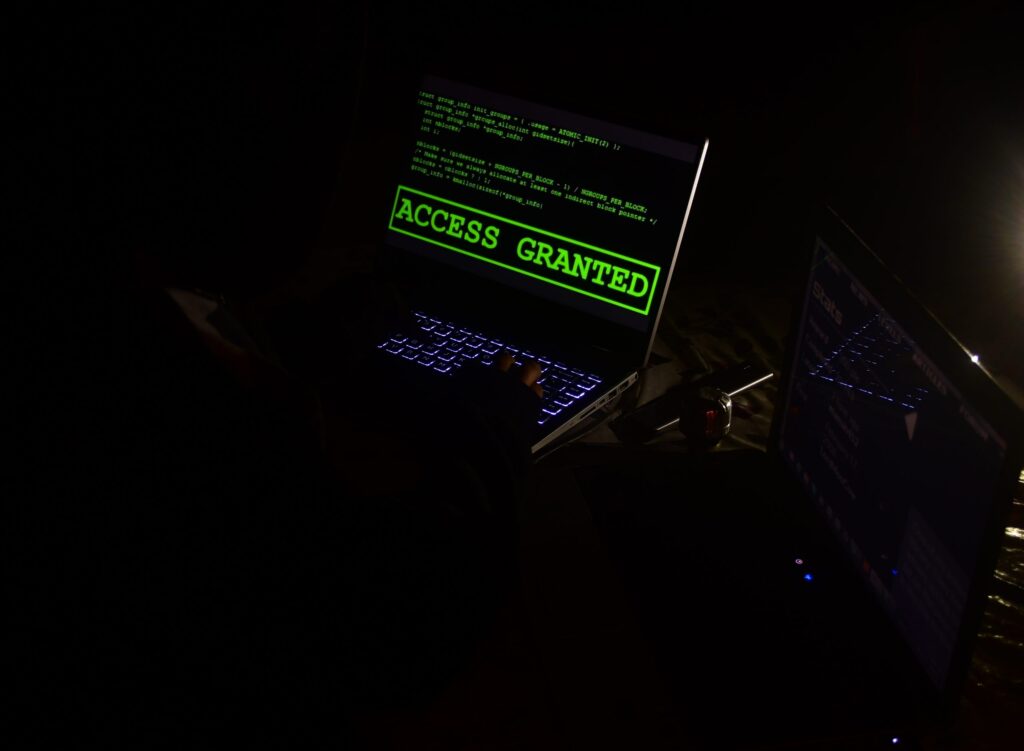

BeyondTrust presenta sus predicciones sobre ciberseguridad para 2024

BeyondTrust, líder mundial en seguridad inteligente de identidades y accesos, ha publicado su predicción anual de tendencias en ciberseguridad para el próximo año. Estas previsiones, elaboradas por los expertos de BeyondTrust, Morey J. Haber, Chief Security Officer; Christopher Hills, Chief Security Strategist; y James Maude, Director de Investigación, se basan en los cambios tecnológicos, los hábitos de los actores de amenazas, la cultura […]

Centro de ciberseguridad británica alerta del riesgo de herramientas de IA para las elecciones

La inteligencia artificial supone un riesgo para las próximas elecciones nacionales británicas, según alertó el martes el centro británico de ciberseguridad, y los ciberataques de países hostiles y sus asociados proliferan y cada vez son más difíciles de rastrear. “Este año ha asistido a la emergencia de actores alineados con estados como nueva ciberamenaza para […]

Uruguay actualiza su Estrategia Nacional de IA e incluye protección de datos personales

El gobierno de Uruguay anunció que su Estrategia Nacional de Inteligencia Artificial incluirá una Estrategia Nacional de Datos. La segunda estrategia buscará incorporar “nuevos pilares” para diseñar acciones adecuadas sobre temáticas que abordará el Estado, academia, sector privado y sociedad civil. La Agencia de Gobierno Electrónico y Sociedad de la Información y del Conocimiento enfatizó que realizarán mesas de diálogo y […]

El uso de la IA en la computación cuántica: el nuevo reto para la ciberseguridad

En un mundo cada vez más conectado y dependiente de la tecnología digital, la ciberseguridad se ha convertido en un pilar fundamental para garantizar la integridad y confidencialidad de la información. A medida que la tecnología avanza a pasos agigantados, surgen nuevas amenazas que desafían constantemente nuestras capacidades para proteger los datos y sistemas críticos. Este es el caso de […]

Latinoamérica mira todavía con desconfianza la IA, pese a su “potencial gigante”

Los avances de la IA están transformando la sociedad, pero en Latinoamérica, persiste la desconfianza debido a limitaciones en el acceso, el miedo a la pérdida de empleos y la reticencia a compartir datos. Los rápidos avances de la inteligencia artificial (IA) y su aplicación para diversas tareas y a nivel empresarial están transformando de forma acelerada […]

No todo es color de rosa en el mundo de la IA: Microsoft alerta sobre la llegada de ciberataques más devastadores

Las cada vez más potentes herramientas de inteligencia artificial (IA) que van apareciendo por estos tiempos están transformando diversas industrias y, por consecuencia, la vida de muchas personas. No es ningún secreto que los algoritmos ya tienen un papel fundamental en la automoción, el comercio electrónico, los recursos humanos, la educación y la ciberseguridad, por mencionar sólo […]

5 beneficios de implementar la Inteligencia Artificial en Ciberseguridad

La Inteligencia Artificial (IA) ha irrumpido con fuerza en el ámbito de la ciberseguridad, revolucionando nuestra aproximación a la protección de sistemas y activos digitales. Las empresas del sector están adoptando la IA en sus estrategias, lo que supone un salto cualitativo en la resiliencia y capacidad de respuesta ante las amenazas cibernéticas. Según un […]

5 tipos de ataques cibernéticos más comunes y cómo la IA está siendo utilizada para perfeccionarlos

Recientemente, la IA (inteligencia artificial) ha sido una de las tecnologías más comentadas en todos los sectores de negocio; y su interés por conocerle se ha visto en aumento. Desde el sector de salud hasta la educación, la IA ha demostrado su potencial para transformar y mejorar diversos ámbitos de la vida humana. Sin embargo, hay […]