- Bogota D.C - Calle 67 N° 7-94 Oficina 604

- 3138834959 - 601 7953297 Ext. 120

Los datos son ahora el activo de mayor valor y cada vez se desarrollan más herramientas para analizarlos, pero para poder darles sentido es necesario anticipar cómo almacenarlos y cómo gestionarlos, contando para ello con la infraestructura correcta.

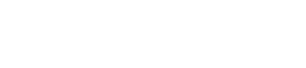

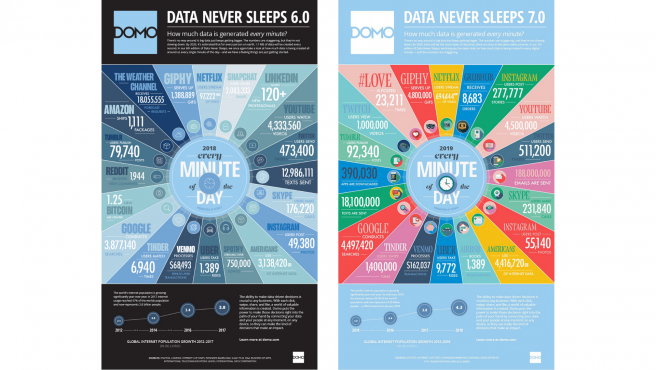

Anualmente, la firma de software en la nube DOMO publica un informe sobre la cantidad de datos recopilados en cada minuto y, como parece presumible, los números aumentan año tras año. El informe de 2019, ‘Data Never Sleeps 7.0’, afirma que este año habrá 40 veces más bytes de datos que estrellas hay en el universo observable. En el gráfico de 2018, se afirmaba que “se crean más de 2,5 quintillones de bytes de datos todos los días” y que se estima que cada persona en la Tierra genera 1,7MB de datos por segundo. Somos 7.75 billones.

El 88% de los directivos a nivel mundial considera la inversión en big data e inteligencia artificial como una necesidad prioritaria, según un estudio de NewVantage Partners, firma tecnológica especializada en la transformación empresarial basada en datos. En España, este mercado tech está siendo uno de los que más rápida y sólidamente está creciendo.

Solo teniendo en cuenta la frenética actividad de los 4.500 millones de usuarios de internet que hay aproximadamente en el mundo parece lógico pensar que se hace necesario tener las soluciones y la infraestructura adecuadas para poder almacenar y gestionar toda la información que esas personas generan.

No hablamos solo de redes sociales o de ocio: cada minuto se envían 188 millones de correos electrónicos, se hacen alrededor de 4,5 millones de búsquedas en Google y más de 200.000 llamadas de Skype. Y estos datos hacen referencia al panorama previo a la crisis sanitaria, puesto que son de 2019.

Pero, ¿qué hacemos con todos esos datos? ¿Dónde se guardan? ¿Cómo se analizan? Para el 81% de las empresas es urgente adoptar un enfoque data driven que les permita gestionar todo este volumen.

“Nosotros ofrecemos un sistema de almacenamiento de fichero que lo que tiene de particular es que es la herramienta en la que se apoyan sistemas de analítica avanzada, de inteligencia artificial, el Internet of Things, la realidad aumentada y la realidad virtual… en definitiva todo lo que tenga que ver con experiencias digitales que lleve peso de contenido multimedia”, informa Vicente Llamas, Dell EMC Storage Sales Specialist, empresa líder en este tipo de almacenamiento según los analistas y, en particular, según la consultora internacional Gartner.

El experto reconoce que muchos proyectos de estas iniciativas tan estratégicas y tan modernas “se quedan en embrión o mueren de éxito” por razones relacionadas con la falta de anticipación en cuanto a pensar en las infraestructuras que van a hacer falta cuando se quieran poner en explotación.

Por ejemplo, en las nubes públicas hay herramientas que la gente utiliza con mucha facilidad para empezar a hacer pequeños desarrollos. “Habrá empresas que sean capaces de hacer aplicaciones muy interesantes, y que encuentren la manera de sacar datos útiles y tener éxito, pero a la hora de ponerlo en explotación hay que tomar decisiones que puede que para muchas compañías sean inesperadas”, como si es posible subir tus datos de cliente a esos espacios, tanto a nivel legal como a nivel de gasto mensual.

Otro inconveniente al que se puede enfrentar un proyecto es tener la aplicación o herramienta desarrollada y el acceso a la base de datos validado, pero tener dificultades a la hora de poner la maquinaria a funcionar porque los datos no están en una única base de datos, sino en diferentes ficheros. Lo explica Llamas: “Muchas veces las herramientas de analítica pueden destinarse a buscar en diferentes plataformas información de un cliente. Por ejemplo, una agencia de seguros que quiere tener todos los datos de un usuario que tengan que ver con deporte, para lo cual hacen una búsqueda de palabras relacionadas en sus redes sociales, en sus audios con el call center, en sus contratos digitalizados, en sus expedientes, en sus transacciones…”.

Por lo tanto, no tener la información que quieres analizar en el sitio correcto, bien porque la herramienta de análisis esté desarrollada en la nube y no pueda subirse ahí la base de datos o bien porque los datos no están correctamente almacenados y estén dispersos en diversos ficheros en vez de en un repositorio único, hace que esos proyectos tan innovadores de analítica o de inteligencia artificial no puedan salir adelante. “No porque no tuvieran sentido o porque no encontraran una manera de hacerlo o el algoritmo ideal, sino porque no tenían preparadas las infraestructuras para ponerlo en producción”, subraya el experto.

“Tenemos la infraestructura perfecta para que esos proyectos tan ilusionantes y tan modernos de esas iniciativas emergentes se puedan poner en producción con plataforma nivel empresa. Funciona en banca, en industria, en administración, en medicina, en multimedia…”, cuenta Llamas.

En todas las empresas hay diferentes servidores de ficheros: de impresión, de gestión documental, de marketing, de los comerciales… en muchas ocasiones hay servidores para cada departamento.

“Si bien esto ha sido así históricamente en las compañías, y antiguamente se suponía que añadía una capa extra en cuanto a ciberseguridad, ahora no es así y tiene el inconveniente de que tienes la información separada, segmentada, y no tienes ninguna herramienta capaz de ponerse a hacer analítica en tus 40, 50 servidores de ficheros aislados”, dice el experto.

En esos casos lo que hay que buscar es un repositorio común de información, pero tiene que cumplir ciertas condiciones: no puede ser un saco donde metas absolutamente todo sin control ni herramientas de gestión del dato, no puede estar a la vista de todos los miembros de la empresa ni que todo el equipo tenga acceso para mover o borrar los archivos y por supuesto debe estar protegido de cara al exterior.

La analítica sobre esta solución tiene varias ventajas, una de las cuales es que es una infraestructura capaz de dar información en tiempo real, frente al Business Intelligence sobre la basa de datos clásica que siempre va a indicar el pasado, es decir, aunque tengas el sistema más actualizado posible, tu base de datos como mucho te va a decir cómo ha estado tu empresa hasta hace un minuto.

“El 80% de lo que almacenan las empresas y las organizaciones públicas son ficheros -documentos ofimáticos, imágenes, vídeos, etc.- que provienen del departamento de marketing, de los sistemas de videovigilancia, de los controles de acceso… esta herramienta puede sacar partido a esa información para ayudar al negocio”, matiza Llamas.

Existen multitud de empresas que se dedican a hacer analítica de imagen médica, proporcionando opción de que los diagnósticos se realicen de una manera mucho más rápida, casi automatizada, e incluso de crear alertas de detección temprana de enfermedades. Un software capaz de analizar millones de radiografías al día y el cual ha sido enseñado con machine learning a detectar una anomalía puede utilizar esa inteligencia artificial aplicada para avisar de un problema de salud.

Por ejemplo: a muchos niños se les hace una radiografía de la muñeca izquierda para ver su nivel de desarrollo, todas esas radiografías de una zona concreta del cuerpo humano muestran o deben mostrar algo que los médicos esperan. Si a un software le enseñas esto, cuando aparezca algo fuera de lugar, una diferencia, no sabrá lo que es pero sabrá que hay algo que no es correcto y será capaz de alertar al sistema, que si está almacenado en una infraestructura de repositorio en tiempo real pondrá esa radiografía inmediatamente en manos de un especialista que podrá corroborar si hay un hallazgo inesperado.

Sin embargo, se trata de una información sensible y, por tanto, no puedes subirla a ningún repositorio público. Si bien actualmente existen muchas empresas que se dedican a anonimizar expedientes médicos para poder coger las imágenes y utilizarlas para investigaciones médicas, haciendo esto “pierdes la capacidad de poder avisar al afectado si surge ese hallazgo inesperado”, expone Llamas. “Nosotros podemos aportar el repositorio correcto para esto: un repositorio privado y común de información entre todos los centros sanitarios y hospitales, de manera que esa información se puede usar no solo para investigar sino también para el diagnóstico temprano”, concluye.

Este sistema se puede aplicar también a otros sectores como la industria. Por ejemplo, se puede controlar la producción de un determinado producto y saber si se está fabricando correctamente mediante la comparación de imágenes finales. Se podrán localizar diferencias -si las hay- y detectar a tiempo un fallo en una máquina.

También se puede usar para saber si los empleados acceden a la fábrica con los equipos de protección adecuados, no solo los aplicables a esta crisis sanitaria, sino por ejemplo si llevan las gafas de protección indicadas. Funciona de la misma manera, solo hay que comparar las imágenes: sería enseñarle al sistema que las caras con gafas son la norma y que pudiera detectar las caras que no las llevasen. “Con PowerScale, además, el sistema no te alerta mañana de que ayer entró alguien sin el debido equipamiento, sino que alerta al momento, de manera que puedes evitar realmente el problema”, finaliza el experto en tecnología y almacenamiento de datos.

¿Por qué es necesario apostar por este tipo de infraestructura? Porque se estima que para el año 2025 el volumen global de datos llegará a la exorbitante cantidad de 175 Zb, o lo que es igual: 175 000 000 000 000 de Gigabytes de datos. Esos miles de millones de imágenes, archivos y documentos de los que hablamos tienen que estar almacenados en el sitio adecuado, para poder ser analizados si queremos que sirvan para algo.